WWDC 2024 : Apple Intelligence, Swift 6, Xcode 16 et un peu d'OpenAI

La conférence développeur annuelle a démarré le 10 juin. La keynote de presque 2h a été plus un fourre-tout qu'autre chose. L'objectif était de présenter l'ensemble des OS (macOS, iOS, VisionOS, tVOS, etc.) et des nouveautés et améliorations. On passait parfois très vite sur les nouveautés les plus intéressantes. RCS arrive sur Messages. Ce support est expédié en 3 secondes et encore sur une slide de récap ! On s'attarde plus sur les nouveautés HomeKit (qui sont enfin intéressantes) que sur Xcode ou Swift. La nouvelle version 6.0 est à peine évoquée. La WWDC doit être au contraire l'occasion de présenter la vision technologique, de présenter les nouveautés les plus importantes, etc. La keynote de la WWDC ressemble de plus en plus une conférence produit Apple. Le fait que ce soit uniquement une keynote enregistrée fairt que nous perdons tout l'intérêt de la conférence et d'avoir un véritable contact avec les équipes. Oui, cela mobilisait des centaines de développeurs d'Apple, mais c'était l'occasion de rencontrer les communautés, de discuter. Apple se trompe profondément en continuer à faire un événement uniquement virtuel. La partie purement développeur se résume à rien ou presque : quelques API et SDK. Bref, pour nous, il s’agit d’une keynote peu intéressante techniquement et trop fragmentée. Quelques annonces de la keynoteLa keynote s'ouvre étonnement sur Apple TV+, mais heureusement on découvre quelques images de Severance saison 2 ainsi que de Silo saison 2. Apple Intelligence est dévoilé dans le dernier quart de la keynote. Sans surprise, Apple injecte de la GenIA, de l'IA dans les OS et les apps. L'objectif d'Apple est de rendre l'IA transparente pour mieux aider les utilisateurs au quotidien : résumé un texte, générer un mail, créer une image, réécrire un mail, résoudre des équitations, transformer un dessin en image, etc. Siri sera enfin remis à niveau après une longue traversée du désert. Apple, grâce à la puissance des CPU, peut se permettre de faire de l'IA locale et des traitements sur son device. Pour les LLM plus importantes, Apple déploie ses propres serveurs et cloud dédié : Private Cloud Compute ! Ce sont des serveurs Apple Silicon (sans plus de détails), un OS dédié écrit en Swift. Apple Intelligence déploie les LLM maisons. Mais Apple permet aussi d'utiliser des modèles et services extérieurs. Un accord avec OpenAI a été annoncé pour pouvoir utiliser ChatGPT par exemple directement dans Siri. Mais attention : ChatGPT, GPT-4o ne sont pas utilisés par défaut. L'utilisateur a le choix de l'utiliser ou d'utiliser les modèles Apple. L'intégration des modèles OpenAI sera sans doute déployée vers l'automne avec les versions finales des différents OS. D’autres serveurs pourraient arriver à la sortie des OS. Platforms State of the UnionLa session Platforms State of the Union est comme chaque année la session la plus attendue. Il s'agit de la véritable keynote développeur. Durant une heure, on peut voir les principales évolutions OS par OS, du langage, des SDK, etc. Une partie de la session est dédiée à Apple Intelligence. Un des défis a été de pouvoir faire l'IA, de la GenIA, localement tout en embarquant des LLM performants. Pour Apple, les défis étaient nombreux : ne pas nuire aux performances du device, ne pas trop chargé la consommation de la batterie (sur iPhone, sur iPad). Les LLM ont été optimisés et compressés. Apple Intelligence mêle donc un traitement local et distant quand cela est nécessaire. Sans plus de détails techniques, la session dévoile un peu plus sur Private Cloud Compute : serveurs Apple Silicon, enclave de sécurité, OS écrit en Swift, pile machine learning dédiée, aucun stockage de données sur les serveurs, pas de shell distant. Cette infrastructure doit être déployée mondialement. Xcode 16 évolue comme chaque année et la liste des évolutions est longue (voir la note de version). Nous pourrons utiliser un CoPilot sauce Apple dans l'IDE. La partie test est une des évolutions les plus importantes (Swift Testing) et la complétion du code, le support des prochains SDK et de Swift 6. La partie Build gagne en performances. Swift est en Ops-in par défaut. Note de version Xcode 16 : https://developer.apple.com/documentation/xcode-release-notes/xcode-16-release-notesSwift 6.0 est donc désormais officialisé. Le langage fête son 10e anniversaire. Un des focus de la v6 est le data-race safety qui termine la longue implémentation de la programmation concurrence. L'équipe Swift rappelle les principales évolutions depuis 10 ans, la stabilisation du langage et des API avec la 5.x et la concurrence. Aujourd'hui, il s'agit de développer l'écosystème et d'étendre le langage au-delà d'Apple comme c'est le cas sur Linux et Windows. Apple promet une migration vers Swift 6.0 la plus transparente possible même s'il faut toujours réécrire du code et migrer la stack. Sur Swift, regardez les sessions What's new in Swift et Migrate your app to Swift 6CarPlays bénéficie aussi de quelques sessions déd

La conférence développeur annuelle a démarré le 10 juin. La keynote de presque 2h a été plus un fourre-tout qu'autre chose. L'objectif était de présenter l'ensemble des OS (macOS, iOS, VisionOS, tVOS, etc.) et des nouveautés et améliorations.

On passait parfois très vite sur les nouveautés les plus intéressantes. RCS arrive sur Messages. Ce support est expédié en 3 secondes et encore sur une slide de récap ! On s'attarde plus sur les nouveautés HomeKit (qui sont enfin intéressantes) que sur Xcode ou Swift. La nouvelle version 6.0 est à peine évoquée.

La WWDC doit être au contraire l'occasion de présenter la vision technologique, de présenter les nouveautés les plus importantes, etc. La keynote de la WWDC ressemble de plus en plus une conférence produit Apple. Le fait que ce soit uniquement une keynote enregistrée fairt que nous perdons tout l'intérêt de la conférence et d'avoir un véritable contact avec les équipes. Oui, cela mobilisait des centaines de développeurs d'Apple, mais c'était l'occasion de rencontrer les communautés, de discuter. Apple se trompe profondément en continuer à faire un événement uniquement virtuel.

La partie purement développeur se résume à rien ou presque : quelques API et SDK.

Bref, pour nous, il s’agit d’une keynote peu intéressante techniquement et trop fragmentée.

Quelques annonces de la keynote

La keynote s'ouvre étonnement sur Apple TV+, mais heureusement on découvre quelques images de Severance saison 2 ainsi que de Silo saison 2.

Apple Intelligence est dévoilé dans le dernier quart de la keynote. Sans surprise, Apple injecte de la GenIA, de l'IA dans les OS et les apps. L'objectif d'Apple est de rendre l'IA transparente pour mieux aider les utilisateurs au quotidien : résumé un texte, générer un mail, créer une image, réécrire un mail, résoudre des équitations, transformer un dessin en image, etc. Siri sera enfin remis à niveau après une longue traversée du désert.

Apple, grâce à la puissance des CPU, peut se permettre de faire de l'IA locale et des traitements sur son device. Pour les LLM plus importantes, Apple déploie ses propres serveurs et cloud dédié : Private Cloud Compute ! Ce sont des serveurs Apple Silicon (sans plus de détails), un OS dédié écrit en Swift. Apple Intelligence déploie les LLM maisons. Mais Apple permet aussi d'utiliser des modèles et services extérieurs. Un accord avec OpenAI a été annoncé pour pouvoir utiliser ChatGPT par exemple directement dans Siri. Mais attention : ChatGPT, GPT-4o ne sont pas utilisés par défaut. L'utilisateur a le choix de l'utiliser ou d'utiliser les modèles Apple. L'intégration des modèles OpenAI sera sans doute déployée vers l'automne avec les versions finales des différents OS. D’autres serveurs pourraient arriver à la sortie des OS.

Platforms State of the Union

La session Platforms State of the Union est comme chaque année la session la plus attendue. Il s'agit de la véritable keynote développeur. Durant une heure, on peut voir les principales évolutions OS par OS, du langage, des SDK, etc. Une partie de la session est dédiée à Apple Intelligence. Un des défis a été de pouvoir faire l'IA, de la GenIA, localement tout en embarquant des LLM performants. Pour Apple, les défis étaient nombreux : ne pas nuire aux performances du device, ne pas trop chargé la consommation de la batterie (sur iPhone, sur iPad). Les LLM ont été optimisés et compressés.

Apple Intelligence mêle donc un traitement local et distant quand cela est nécessaire. Sans plus de détails techniques, la session dévoile un peu plus sur Private Cloud Compute : serveurs Apple Silicon, enclave de sécurité, OS écrit en Swift, pile machine learning dédiée, aucun stockage de données sur les serveurs, pas de shell distant. Cette infrastructure doit être déployée mondialement.

Xcode 16 évolue comme chaque année et la liste des évolutions est longue (voir la note de version). Nous pourrons utiliser un CoPilot sauce Apple dans l'IDE. La partie test est une des évolutions les plus importantes (Swift Testing) et la complétion du code, le support des prochains SDK et de Swift 6. La partie Build gagne en performances. Swift est en Ops-in par défaut.

Note de version Xcode 16 : https://developer.apple.com/documentation/xcode-release-notes/xcode-16-release-notes

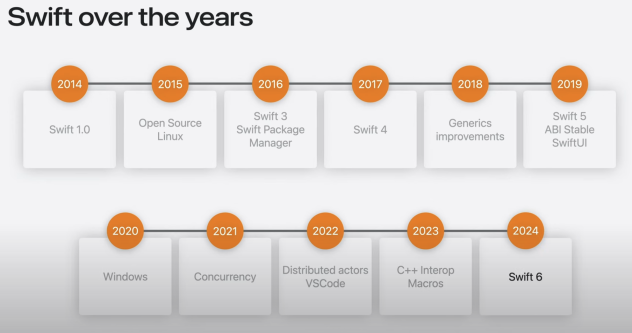

Swift 6.0 est donc désormais officialisé. Le langage fête son 10e anniversaire. Un des focus de la v6 est le data-race safety qui termine la longue implémentation de la programmation concurrence. L'équipe Swift rappelle les principales évolutions depuis 10 ans, la stabilisation du langage et des API avec la 5.x et la concurrence. Aujourd'hui, il s'agit de développer l'écosystème et d'étendre le langage au-delà d'Apple comme c'est le cas sur Linux et Windows. Apple promet une migration vers Swift 6.0 la plus transparente possible même s'il faut toujours réécrire du code et migrer la stack. Sur Swift, regardez les sessions What's new in Swift et Migrate your app to Swift 6

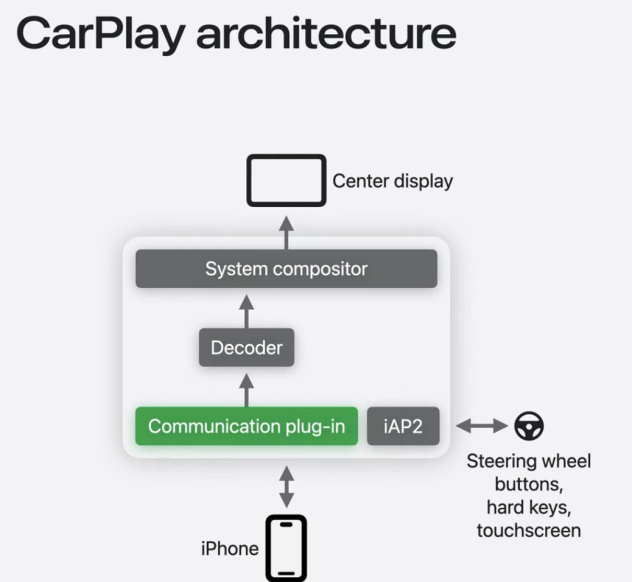

CarPlays bénéficie aussi de quelques sessions dédiées. L'arrêt du projet Titan n'empêche pas Apple à continuer à étendre son système embarqué CarPlay. Les futures versions sont présentées durant la WWDC : interface plus intégrée, prise en charge de la configuration de la voiture, interface locale s'appuyant sur un rendu OpenGL, support des capteurs et caméras, nouvelle aide visuelle à la conduite, etc.

Sur ce sujet, deux sessions :

- Say hello to the newt generation of CarPlay design system

- Meet the next generation of CarPlay

Apple met en ligne les sessions de la WWDC.